星海网盘

星海网盘可以同时挂载在同个大区所有实例上,在实例与实例之间建立文件传输通道,文件放到星海网盘里,所有挂载星海网盘的实例里都能立即看到并可以管理此文件。

放在星海网盘中的文件不会因为该实例的删除而删除。

(PS:Linux实例和Windows实例在同一个大区的网盘也是互通的。超过30天未登录,网盘数据会被清除。)

星海网盘免费容量50GB,存储总容量为1024G,为方便大家使用,将超出的容量收费下调至0.005元/GB/日。

经测试,实例调用网盘文件最高读取速度可达1Gb/s。

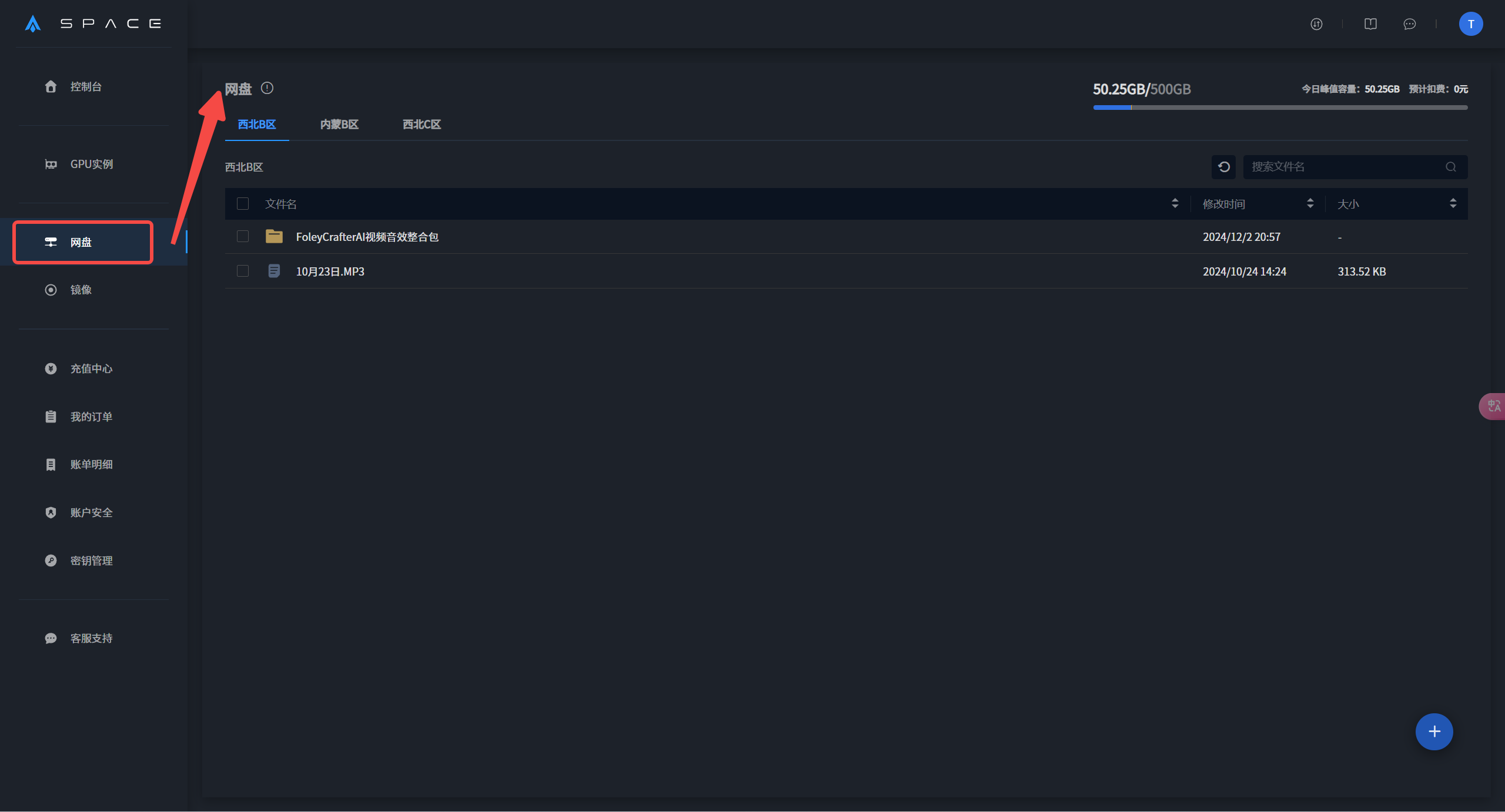

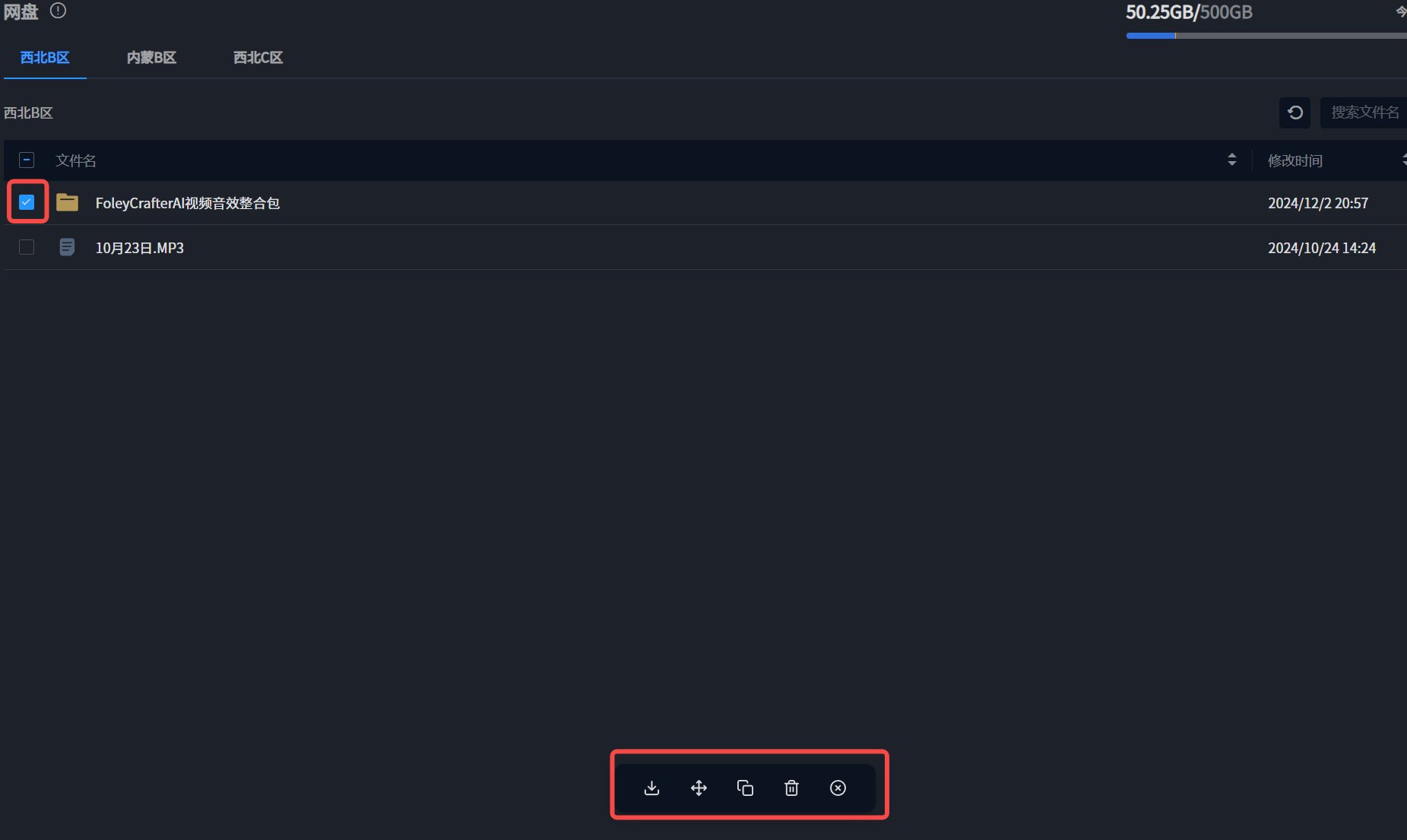

网盘界面

点击主界面左侧栏目中的网盘选项,即可打开网盘界面。

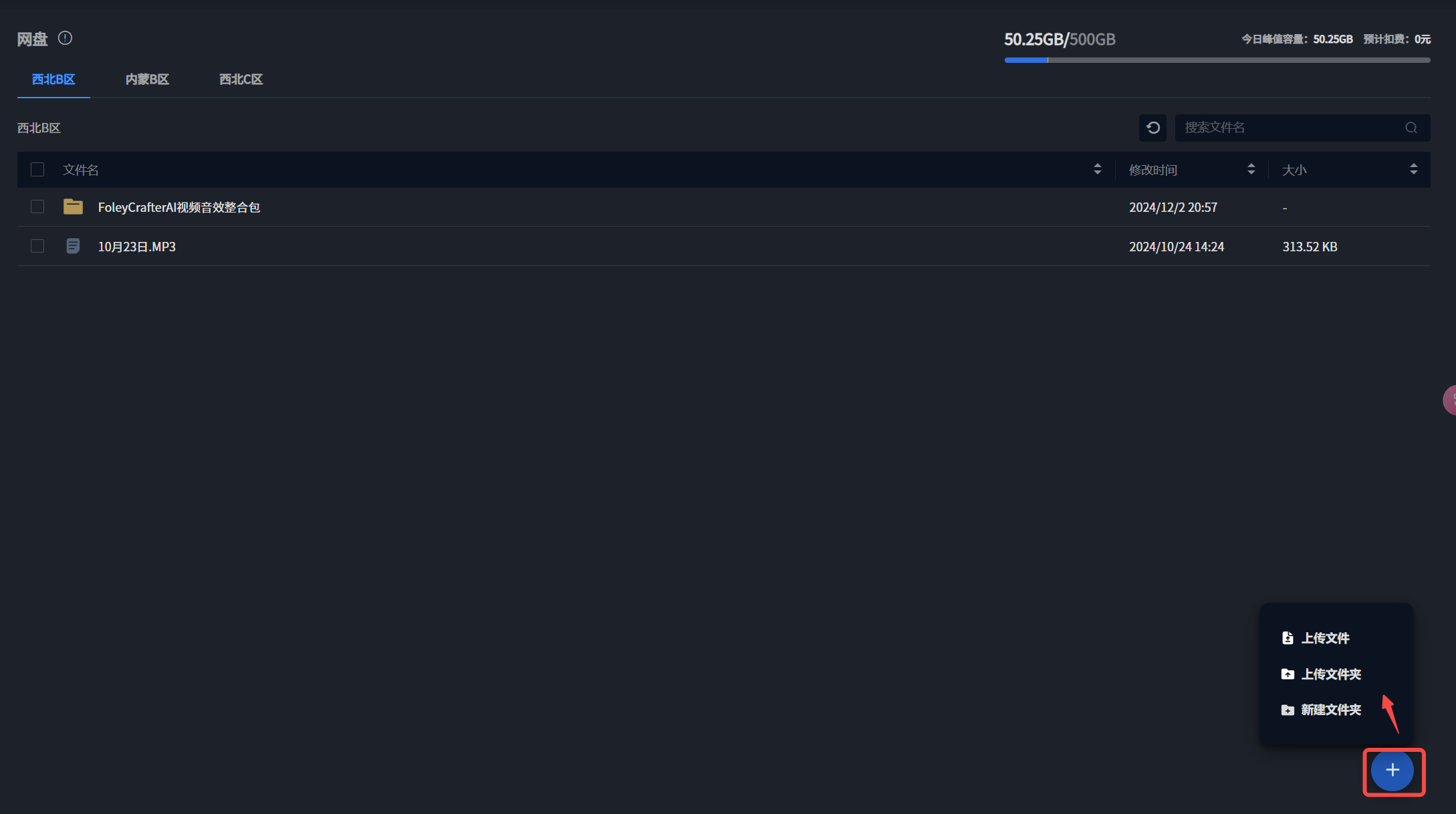

上传

点击网盘界面右下角蓝色+,会显示上传相关操作。

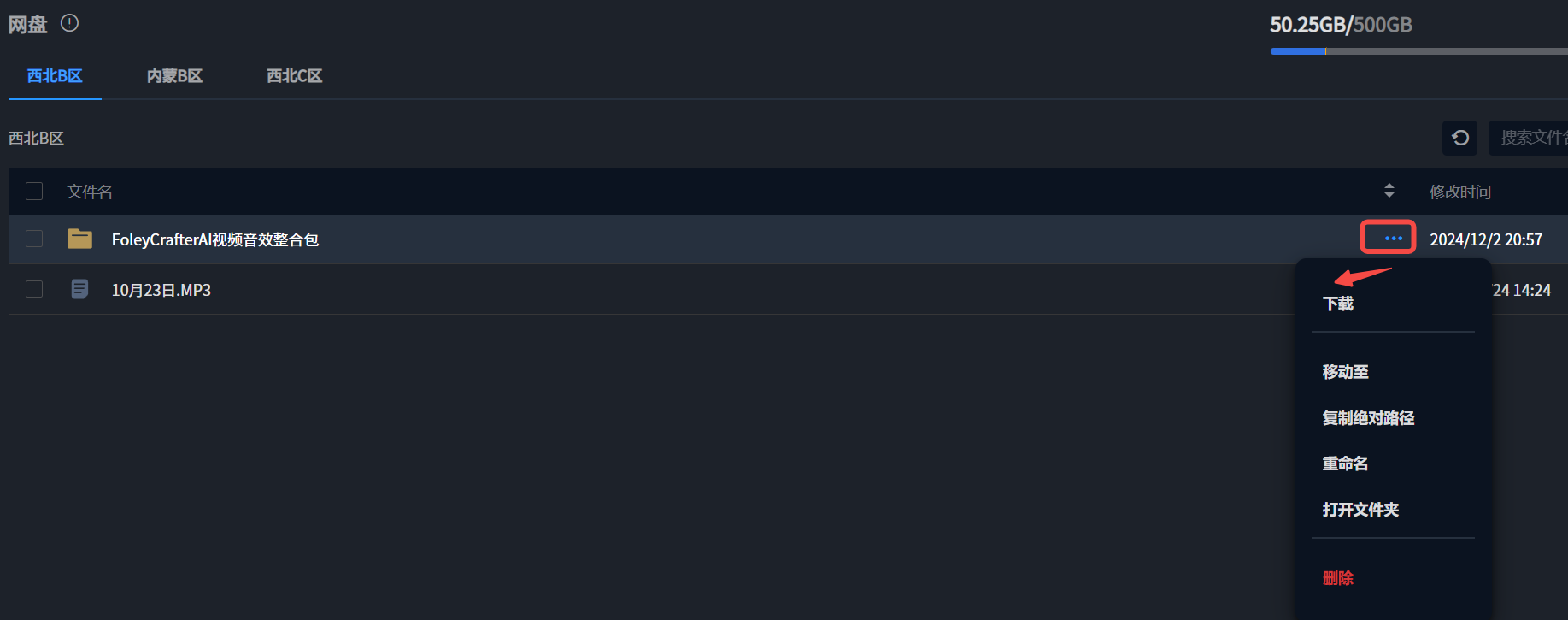

相关操作

点击文件右侧蓝色···,或选中相关文件,即可进行网盘文件的相关操作。

网盘文件使用

实例只能调用同一个大区的网盘文件。

一、下载

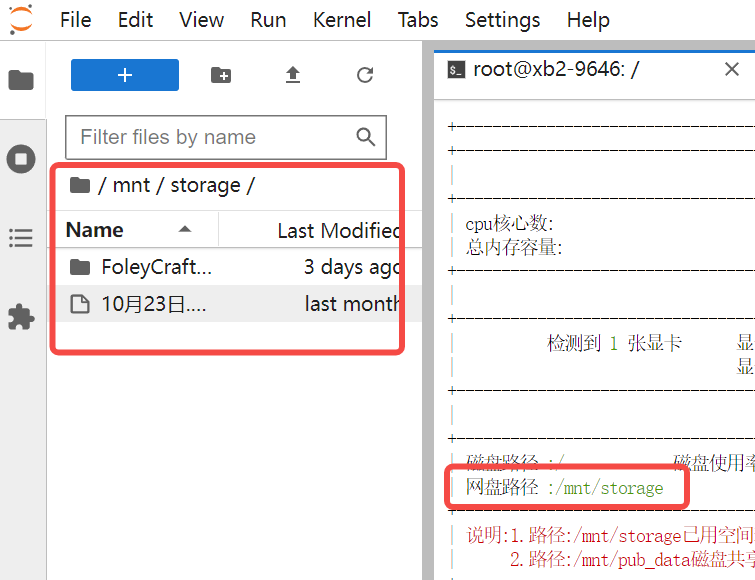

Linux

Linux系统中星海网盘默认路径为/mnt/storage

Linux系统实例打开jupyterlab,可以在mnt/storage路径下看见自己的网盘文件。

第三方网站上的文件可以通过以下命令下载到指定目录

wget -nc -P /mnt/storage/ url #url为文件的网页链接Windows

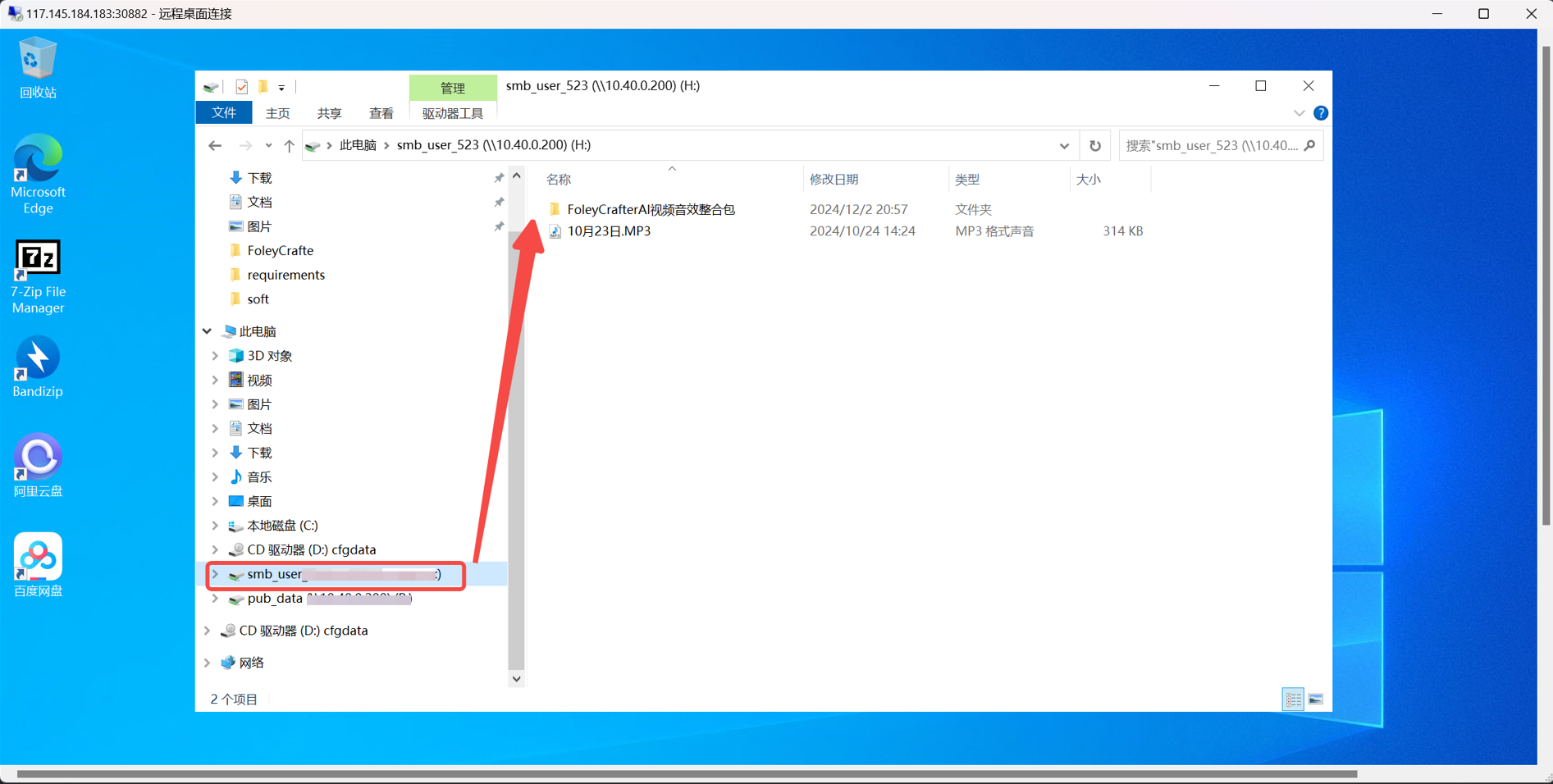

Windows系统中星海网盘默认路径为H:\

Windows系统实例远程连接后,可以在文件资源管理器目录下看见网盘文件。

二、数据使用

1.直接调用

ComfyUI

ComfyUI的默认路径为ComfyUI/models,但ComfyUI支持设置其他目录为模型存放目录,设置方法为修改ComfyUI文件夹下extra_model_paths.yaml.example文件,该文件用于拓展模型路径。 可以参考以下配置

a111:

base_path: /mnt/pub_storage/aigc_models/MumuxiTools/ComfyUIModels

#以上是Linux系统的,Windows系统的分隔符是\,如P:\aigc_models\MumuxiTools\ComfyUIModels

checkpoints: models/checkpoints

# 若需要访问多个文件夹可以参考以下内容

# checkpoints:|

# models/checkpoints

# models/LLM/checkpoints

configs: models/configs

vae: models/vae

loras: |

models/Lora

models/LyCORIS

upscale_models: |

models/ESRGAN

models/RealESRGAN

models/SwinIR

embeddings: embeddings

hypernetworks: models/hypernetworks

controlnet: models/controlnet

custom_nodes: custom_nodesollama

ollama可以设置环境变量

1、停止ollama服务

sudo systemctl stop ollama

sudo systemctl disable ollama.service2、确保模型目录可访问与写入,且确保存在模型

3、修改ollama配置文件

vim /etc/systemd/system/ollama.service4、在Service部分的Environment字段后,添加新的Environment字段,指定新的模型路径:

Environment="OLLAMA_MODELS=/mnt/storage/ollama/models"并修改user和Group值为root,确保拥有权限。

修改完如下

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="PATH=/usr/local/cuda-12.4/bin:/root/miniconda3/bin:/root/miniconda3/condabin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/snap/bin"

Environment="OLLAMA_MODELS=/mnt/storage/ollama/models"

[Install]

WantedBy=default.target修改完配置后,ollama模型会默认下载到网盘

5、重启服务

sudo systemctl daemon-reload

sudo systemctl enable ollama.service

sudo systemctl restart ollama2.拷贝数据

Linux

cp /path/to/source/file /path/to/destination/folder/Windows 直接复制粘贴

注意事项