【Ollama-OpenWebUI镜像】Linux云部署教程

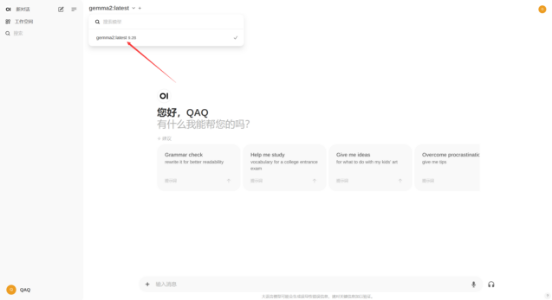

1、GPU工作状态验证及初始化系统

nvidia-smi在云部署前,请先查看显卡状态,如果出现异常请及时联系平台客服解决

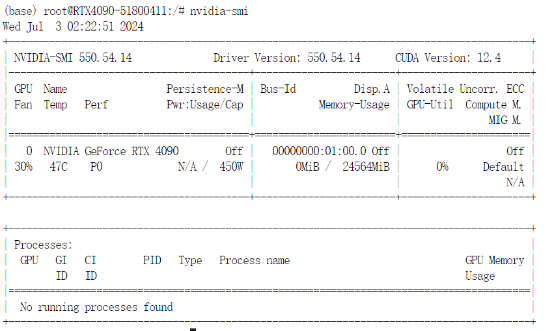

查看完显卡状态后,对现有的Ubuntu镜像的系统软件、显卡驱动、各应用软件进行升级以满足自身需求

apt update && apt upgrade

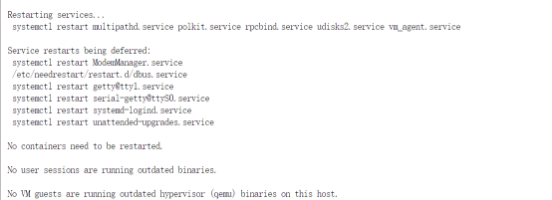

执行后需要输入Y回车,因为输出内容过多,本文档只展示最终完成结果

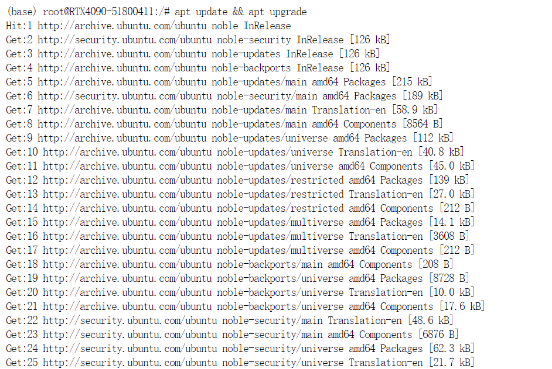

选择install the package maintainer's version,整个安装的过程较长,请耐心等待

完成后系统会自动进行重启,点击Terminal重新进入终端即可

2、安装Ollama服务

Ollama官网地址:https://ollama.com/

进入官网之后点击download,选择Linux版本下载,直接复制下载命令

在此之前,可选择进行学术加速加快下载速度

source /etc/network_turbo如下图所示,说明Ollama服务安装成功

3、配置模型下载地址到网盘共享目录

为了既不占用云主机的本地硬盘,同时假如多开服务器的话,又可以共享给自己账号里其他云主机使用 ollama 模型,无需重复下载。因此,迁移ollama软件安装目录到网盘目录。

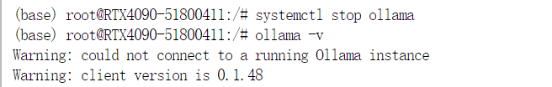

按顺序执行以下命令即可,先停止已经启动的ollama服务

systemctl stop ollama

ollama -v

再次提醒,必须看到Warning: client version is 0.1.48才能继续操作

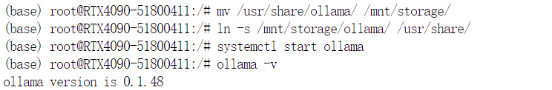

再执行以下命令

mv /usr/share/ollama/ /mnt/storage/

ln -s /mnt/storage/ollama/ /usr/share/

systemctl start ollama

ollama -v对以上的几个命令进行简单解释:

Mv 是把ollama默认安装的位置剪切到网盘目录去

ln 命令是把网盘目录的ollama再创建一个软连接放回到默认路径

Systemctl start 是再次启动ollama服务

注意执行mv命令的时候千万不要中断,否则就得重新安装ollama才能确保不丢失文件了

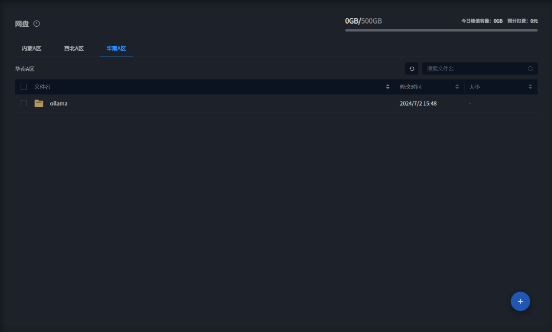

执行完成之后,可以在个人网盘中看见ollama文件夹,请勿随意移动,任何删除、改名、移动位置操作都会导致ollama服务无法启动

4、安装Open-Webui

安装open-webui的目的是方便通过web方式去图形化使用ollama服务

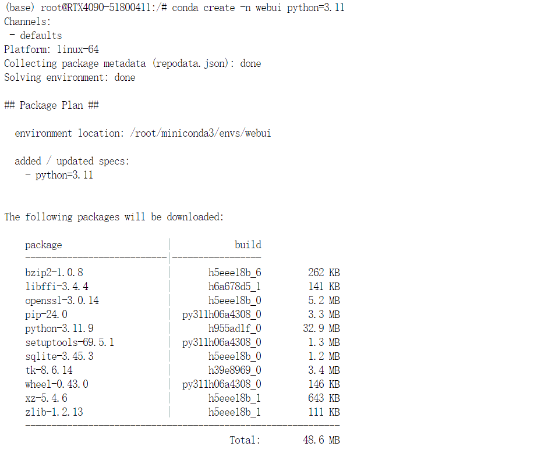

首先通过conda创建一个python3.11版本的虚拟环境,防止多个环境在云主机里并存从而造成冲突

conda create -n webui python=3.11

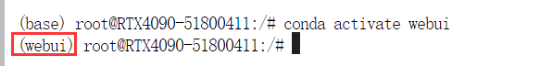

创建完成后,激活虚拟环境

conda activate webui

看见base->webui说明成功进入到创建的虚拟环境中

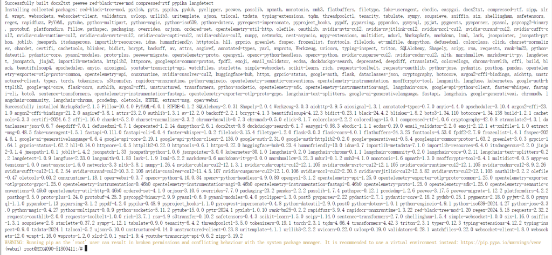

使用pip命令安装webui,执行以下命令

pip install open-webui -i https://pypi.tuna.tsinghua.edu.cn/simple

下载安装过程会比较久,请耐心等待

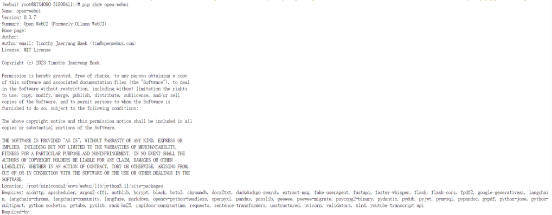

检查open-webui安装是否成功,正常安装后显示如下

pip show open-webui

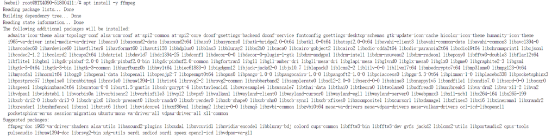

安装open-webui依赖的ffmpeg,否则启动时会报错

apt install -y ffmpeg

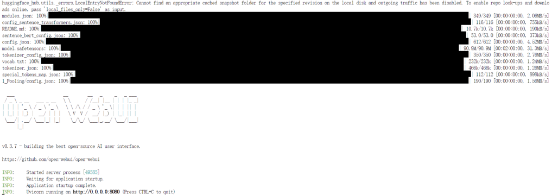

5、启动Open-webui并进行SSH隧道映射web服务

第一次启动时,会自动下载huggingface依赖环境,所以需要先执行加速命令

source /etc/network_turbo

open-webui serve

最后出现running on http://0.0.0.0:8080 就说明启动成功后,注意在使用过程中不要关闭ssh窗口也不要按ctrl+c

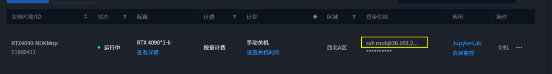

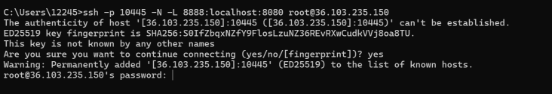

成功启动后,使用ssh隧道映射web服务,新开一个窗口后输入如下格式的命令

ssh -p xxxxx -N -L 8888:localhost:8080 root@xxx.xxx.xxx.xx

将实例界面的信息复制后填入即可

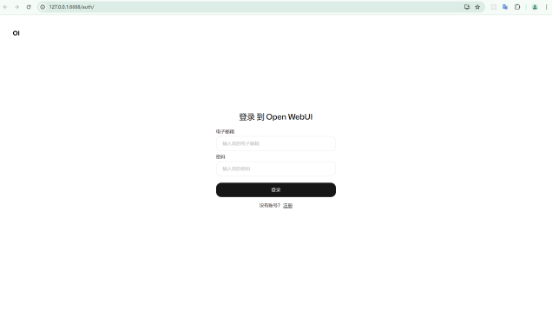

浏览器输入http://127.0.0.1:8888即可访问

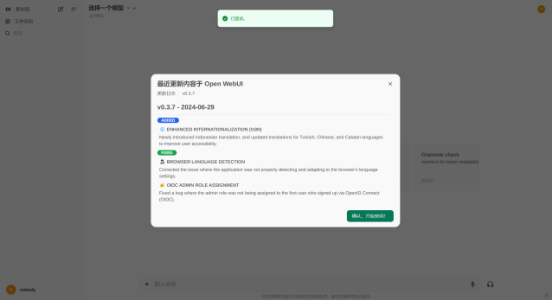

注册或者登录账号后即可使用

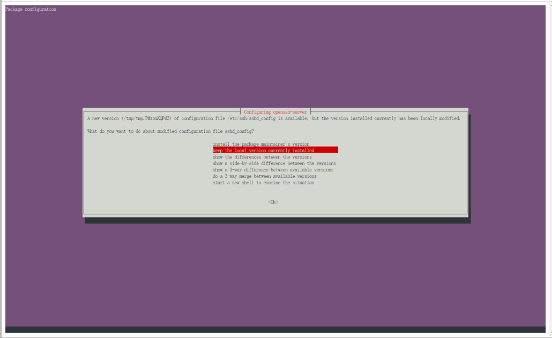

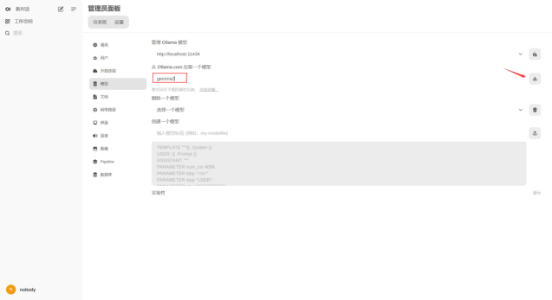

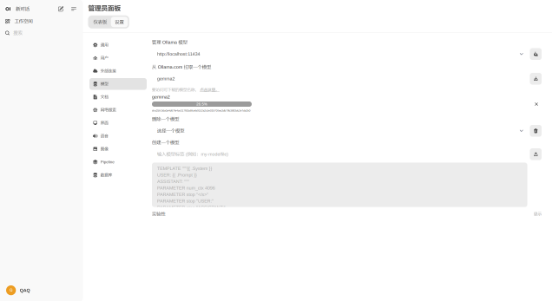

点击左下角头像,点击管理员面板,选择模型,进行模型下载

输入模型名称后,点击右侧进行下载

模型下载完毕后可进行对话,以gemma2为例,下载后可以在界面内选择已经下载的模型